Como muchos de vosotros, estos últimos meses he tenido algo más de tiempo de lo habitual, porque no tener que ir a diario a la oficina implica no tener que perder tiempo en transporte de ida y vuelta. Además, no poder salir de casa salvo lo imprescindible, hace que tengas… Leer más »

Hacía ya algunos años que no había surgido la oportunidad de presentarme a un curso de certificación, y aprovechando que estas semanas estoy haciendo varios cursos sobre Azure, hoy me presentaba al primero de ellos: 70-533: Implementing Microsoft Azure Infrastructure Solutions Es un examen complicado, porque muchas de sus preguntas son… Leer más »

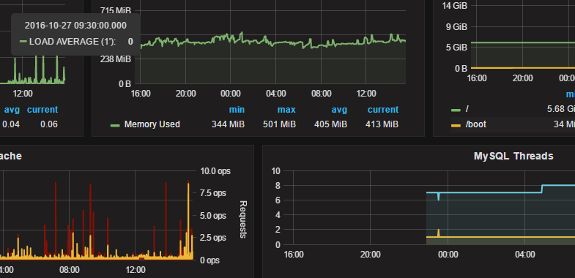

Aprovechando el cambio de hosting para este blog y otras cosas, me ha dado por buscar formas de visualizar estadísticas de rendimiento del servidor, y tener controlados todos sus recursos típicos: CPU, memoria, disco, … Esta búsqueda me ha llevado a descubrir estas tres herramientas: Grafana: Es una herramienta para… Leer más »

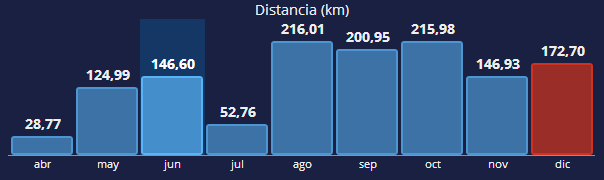

Llega el último día del año, y con él la hora de hacer balance de algunos aspectos que nos ha traído el año 2013. Por un lado, alguno de mis objetivos han quedado muy lejos, como ya esperaba realmente y al mismo nivel que años anteriores: libros leídos en 2013. Es… Leer más »

La verdad es que llevaba bastante tiempo necesitando utilizar alguna herramienta para gestionar mis lista de tareas pendientes, pero hasta hace unos días no me había puesto a hacer una búsqueda activa. Estos días he estado probando algunas de las comentadas habitualmente como las mejores herramientas de gestión de tareas,… Leer más »

El pasado Domingo participé en la I Carrera Cerro de la Marmota 2011, y el resultado no fue el esperado. Era mi primera carrera larga, 25 km, que no me asustaban demasiado excepto por las molestias que venía sufriendo desde hace 3-4 semanas en mi rodilla derecha. Como me temía,… Leer más »

Vaya, nunca pensé que dedicaría voluntariamente parte de mi tiempo libre a una de las actividades más primarias del ser humano: andar, correr, disfrutar del paisaje, de la naturaleza, estar con uno mismo, sumar kilómetros, en resumen, correr por correr. Yo era de esos que hasta hace pocos meses decía:… Leer más »

Ante la inclusión en el Anteproyecto de Ley de Economía sostenible de modificaciones legislativas que afectan al libre ejercicio de las libertades de expresión, información y el derecho de acceso a la cultura a través de Internet, los periodistas, bloggers, usuarios, profesionales y creadores de internet manifestamos nuestra firme oposición… Leer más »

Hace unas semanas hice los dos cursos de Administración de Solaris 10, en concreto los del SCSA (Sun Certified System Administrator), el System Administration for the Solaris 10 Operating System (Part I) y el System Administration for the Solaris 10 Operating System (Part II). Conseguí hacerlos en Core Networks, uno… Leer más »

Después de muchos años manteniendo en casa mi propio servidor conectado al ADSL para servir contenidos web, correo, listas de correo, … creo que ya ha llegado el momento de contratar algo un poco más profesional, y sobre todo con mejores tiempos de respuesta para las pocas cosas que mantengo… Leer más »